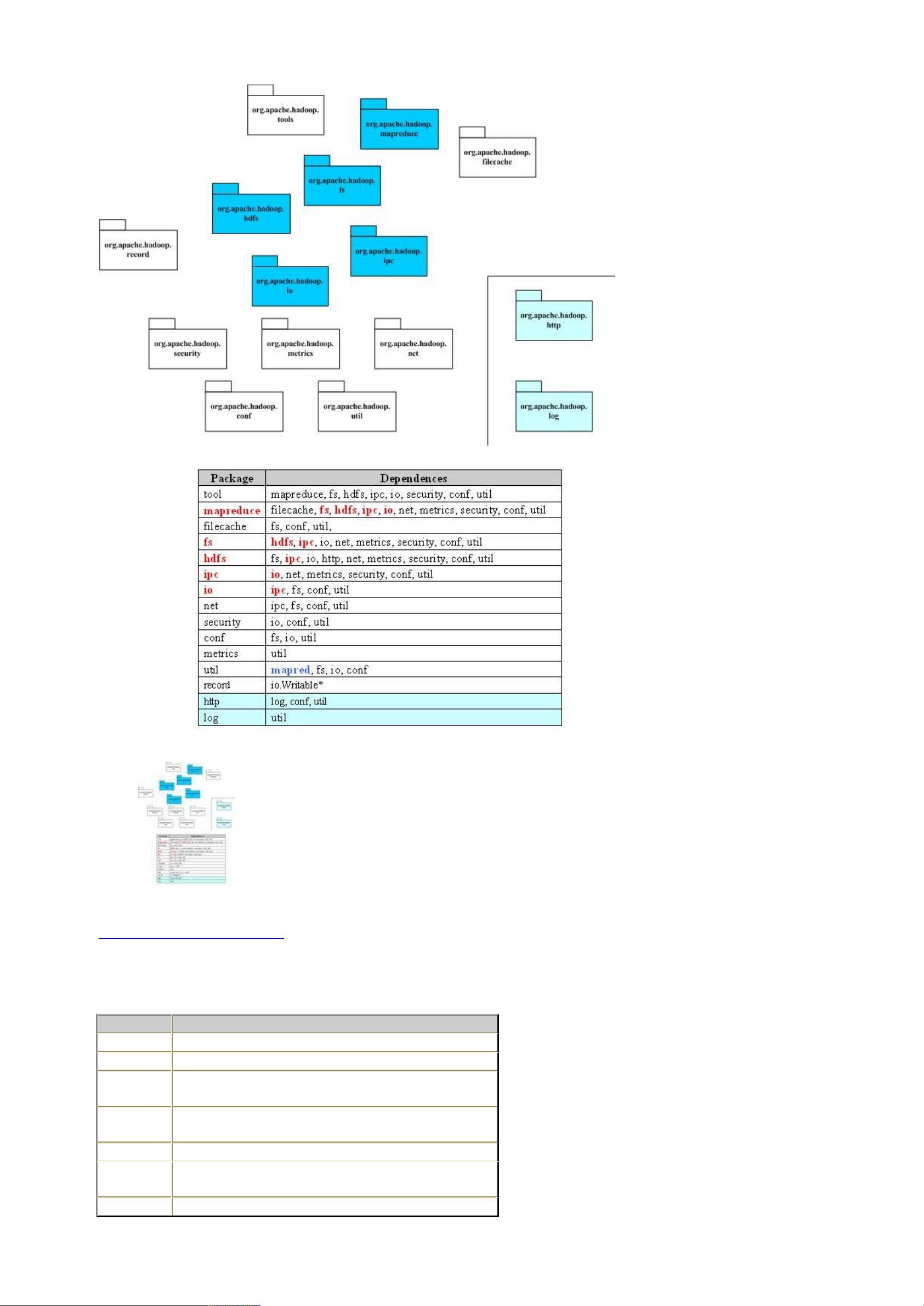

Hadoop是开源的分布式计算框架,它主要由两个核心组件构成:HDFS(Hadoop Distributed File System)和MapReduce。这两个组件共同构建了一个强大的、可扩展的云计算平台,旨在处理和存储海量数据。 HDFS是分布式文件系统,灵感来源于Google的GFS(Google File System)。HDFS的设计目标是在廉价硬件上实现高容错性和高吞吐量的数据存储。它通过数据复制策略确保数据的可用性,允许在节点故障时快速恢复。HDFS的API设计使得开发者可以透明地访问分布式存储,无论是本地文件系统还是像Amazon S3这样的云存储服务。 MapReduce是Hadoop中的并行计算模型,借鉴了Google的MapReduce论文。Map阶段将大型输入数据集分割成小块,然后在集群的不同节点上并行处理。Reduce阶段则将Map阶段的结果聚合起来,生成最终输出。这种模型非常适合大规模数据处理任务,例如数据分析、搜索索引构建等。 Hadoop的源码分析涵盖了多个关键包,包括: 1. `fs`包提供了文件系统的抽象接口,使得不同类型的文件系统(如HDFS、本地文件系统、S3等)可以统一访问。 2. `hdfs`包是HDFS的具体实现,包括数据块管理、数据复制、故障恢复等功能。 3. `ipc`包实现了简单的远程过程调用(RPC)机制,用于节点间的通信,依赖于`io`包提供的编解码功能。 4. `io`包处理数据的编码和解码,确保数据在网络中有效传输。 5. `net`包包含了网络相关的功能,如DNS解析和Socket通信。 6. `security`包处理用户身份验证和权限控制。 7. `util`包包含通用工具类,提供各种实用功能。 8. `record`包允许根据DDL生成编解码器,用于自定义数据类型。 9. `metrics`包负责系统性能指标的收集和监控。 10. `archive`和`tool`包提供了管理和维护Hadoop集群的工具,如DistCp用于数据复制。 11. `webapps`包包含HTTP服务器和Servlet,用于通过Web界面查看系统状态和日志。 在Hadoop的序列化机制中,`org.apache.hadoop.io`包定义了许多实现了`Writable`接口的类。`Writable`接口定义了对象如何写入和读取数据流,这是Hadoop内部通信的关键。例如,自定义的`MyWritable`类会实现`write`方法,将成员变量`counter`和`timestamp`写入`DataOutput`。 通过深入分析Hadoop的源码,我们可以理解其内部工作原理,优化性能,或者开发新的功能和扩展。这对于任何希望利用Hadoop进行大数据处理的开发者来说都是至关重要的。Hadoop的源码分析文档提供了宝贵的参考资料,有助于开发者更好地理解和利用这个强大的框架。

剩余63页未读,继续阅读

- 粉丝: 1

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- plc和变频器在中央空调中的应用--毕业汇编.doc

- 基于MATLAB的混沌序列图像加密程序.doc

- (完整版)移动通信期末考试重点知识点总结.doc

- access学生成绩管理系统数据库.pdf

- 5000字计算机生产实习报告.docx

- 房地产全面信息化解决方案.doc

- Excel操作题2(最新整理).pdf

- 2023年计算机四级数据库工程师历年真题及答案自己总结.doc

- 串口通信工具的设计与实现中文翻译.doc

- 2014北工大计算机考研复试笔试真题.doc

- 网站建设方案合集大全.docx

- (完整版)基于matlab对图像进行高通、低通、带通滤波.doc

- 操作系统——精髓与设计原理(第五章答案).ppt

- 基于单片机智能小车--毕业设计名师资料合集.doc

- 微探会计信息化发展.doc

- 网站建设项目策划方案.doc

信息提交成功

信息提交成功